当今,全球每分钟的网络交易量近9000万笔,也就是每秒钟交易150万次。全部的电子邮件、应用下载、流视频、社交媒体交互、零售购买等等,都是通过一个全球性的数据中心网络来实现的。在交换机、路由器及冷却设备所构成的网络的支持下,这些数据中心可以容纳多达1万台的服务器–而这一切都要依靠越来越多的电力才能良好运行。

一、电力的转换和分配

数据中心采用一种称为“电源单位效率”的方法来评估电源架构的效率,也称为PUE。PUE是将输送到数据中心的总功率除以输送到关键负载(服务器)的功率,而理想的PUE值为 1。举例来说,1.7的PUE意味着,每向负载输送一瓦的功率,在配电和冷却上就要损失掉0.7瓦。据报道,2018年对数据中心测得的PUE水平在1.6左右。最重要的转换过程之一就发生在机架上。为了达到所需的计算能力,会需要数千台的服务器。除了服务器以外,还通过交换机来管理服务器之间、以及从服务器到外界的通信。在大量的电力所输送到的机架上,容纳着30到35台的1U服务器,这些服务器正在逐步通过3千瓦的供电机组(PSU)来供电。PSU通常位于机架的底部,可以将电力转换成电压水平各不相同的电源轨。以208伏直流电压进入到 PSU 的电力将转换为 3.3、5和12伏的电源轨,从而满足服务器和交换机内部各种不同组件的需求,例如含处理器的母板、适配器卡和显卡、PCIe 和内存等等。此外,机架中还会有提供冷却气流所需的大量风扇。输送到服务器的很大一部分电力都会转换成热量。在电力从交流转换成直流、以及从直流转换成直流的过程中,作为转换过程中一个自然而然的组成部分,就会发生这种热损失。

二、空间上的挑战

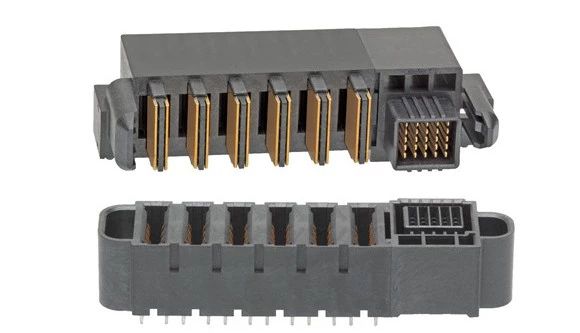

对这种与日俱增的功率进行管理,在涉及到封装空间和热管理时,就会产生巨大的挑战。尽管对电源的需求一直在稳步提升,为电源以及背部的重要连接器分配的空间却并没有发生过变化。回到服务器部署的早期时候,服务器系统基础设施(SSI)要求使用400到600瓦的电源,而电源I/O则会使用四到六台叶片式电源,其中每个叶片的额定电流为30安,从而将所需的功率输送到服务器。时至今日,对于连接器企业的要求则是电源I/O在相同空间内承载的电流能够达到以前的三倍。

三、提高密度

连接器的设计人员现在不得不去考虑各种具有创造性的解决方案,从而对热量和电流进行管理。尽管在连接器的额定值计算中不能将气流考虑在内,目前在外壳中经常会设计通风功能,以便耗散掉热量并防止过热。基础的物理学知识告诉我们,为了承载更多的电流,需要的只不过是更多的铜材料。在铜合金领域取得的进步使得可以提高导电性,而这些进步并不会跟得上对更高电流密度的需求。同样,触点设计上的改进可以改善PSU 接口和连接点之间经常发生的功率损耗的情况,这种连接点可能是互连系统的插入部分,有时候也会是印刷电路板的卡边缘,但是并不能依靠这些改进成果来显著的提高电流密度。广大的客户目前正要求连接器的设计人员来减小电源触点之间的中线间距;然而,缩小间距会在印刷电路板的体积上以及连接器本身的内部造成相互发热的问题。连接器在过去40年来主要围绕着提高密度而发展。但是,业界现在正在走向这样一个阶段,那就是必须考虑增加空间以提高功率,或者是对用于评估连接器性能和额定值的惯例进行检验。据认为,数据中心的电效率每提高1%,就会节省数以百万美元计的成本。由于节省成本的潜力是如此之大,在数据中心的业主、电气公用事业的提供商以及政府官员之间,那场积极活跃的讨论当然还会继续进行一段时间。